高通发布专用AI加速器Cloud AI 100,百度阿里腾讯

我们都认识高通,可能大部分人是通过骁龙移动处理器。过去的高通是世界上最大的移动处理器提供商,但是今天的高通想要让人们重新认识它。

如果一切顺利的话,几年之后回望今天,可能会是历史性的一天。

2019年4月9日,在旧金山举行的高通 AI Day 上,这家芯片技术巨头正式宣布进军云计算市场,并宣布了面向人工智能推理计算的第一枚专用 AI 加速器:Qualcomm Cloud AI 100。

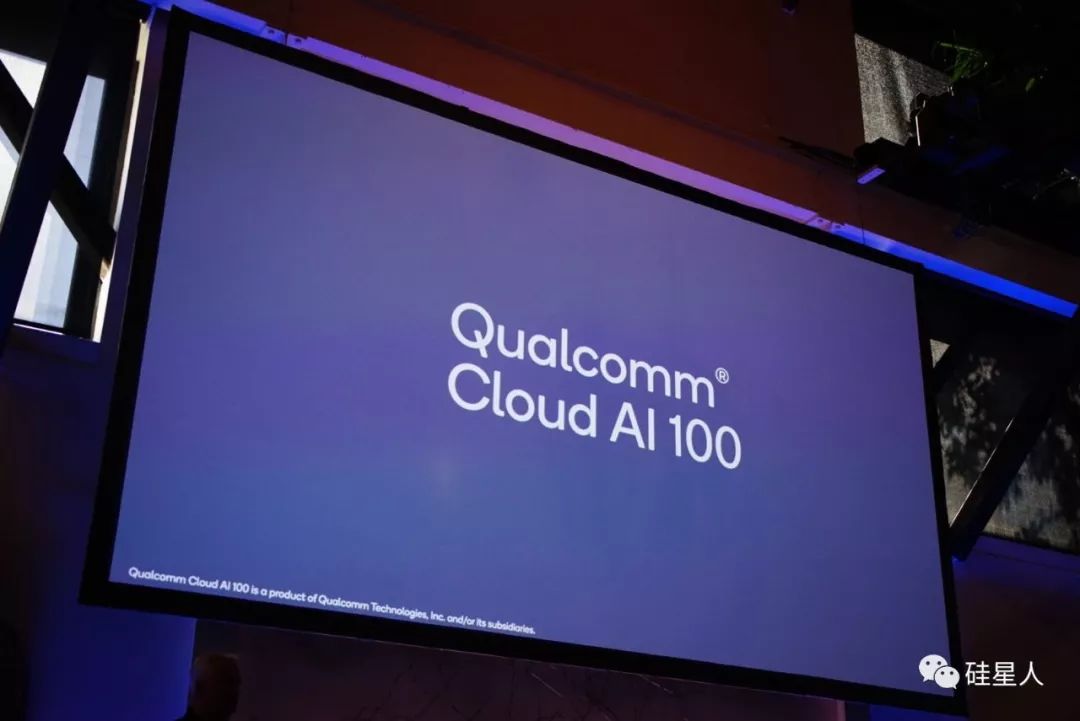

根据高通的定义,Cloud AI 100 是一枚面向特定用途的专用 AI 加速器 (purpose-built AI Accelerator)。目前公开的的技术详情并不多,已知信息和合理猜测告诉硅星人,这是一套高通设计的 ASIC(专门集成电路)。

现场演示视频提到,Cloud AI 100 是一枚专门面向“人工智能推理”的 AI 加速器。这是一个领域内的术语,翻译过来就是:Cloud AI 100 可以用来运行预先训练好的深度学习算法和神经网络。

如果你还不理解这到底是个什么东西——听说过 TPU 吧?这是 Google 最近几年最令人激动的硬件之一,在公司内部取代了前几年广泛采用的 GPU 集群,成为了 AI 计算领域的标杆式硬件——Cloud AI 100 就是“高通版 TPU”,但是目前聚焦在机器学习的推理,而非训练上。

Cloud AI 100 采用7纳米制程,高通宣称单片的计算性能达到350TOPS(每秒万亿次计算,≠TFLOPS)。

横向简单比较不同 AI 加速器的计算能力的意义不大,不过这里方便读者理解就把数值放出来:Cloud AI 100 可以达到350TOPS;Google TPU 一代在250W下的测试结果是92TOPS;TPU 二代的浮点计算性能是45TFLOPS;三代是二代的大约两倍。

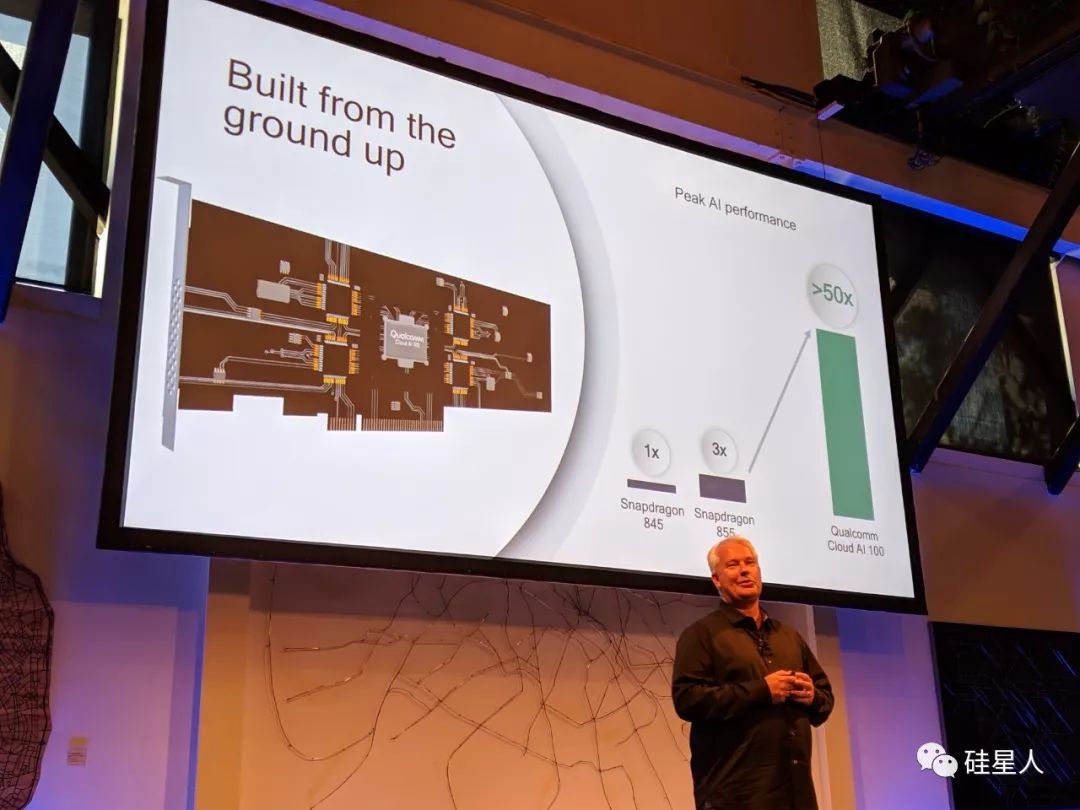

高通宣称,和其他 AI 推理硬件解决方案(GPU、CPU 和 FPGA)相比,Cloud AI 100 在性能功耗上能够达到10倍的提升,和高通骁龙处理器的片上 AI 计算能力相比则有50倍的提升。

目前阶段,高通拒绝透露特定功耗下 TFLOPS 等更多参数,不过高通技术公司产品管理高级副总裁 Keith Kressin 表示,他们已经将技术细节告知了中国、美国的多家云服务提供商,“他们告诉我们,如果能达到这个参数(TFLOPS 或 TOPS),Cloud AI 100 无疑将是最好的方案。”

虽然在性能上和 TPU 的诧异仍不清楚,Cloud AI 100 对 AI 行业五花八门的框架支持是比较优秀的:Google 主导的 TensorFlow、Facebook 主导的 PyTorch、Keras、亚马逊主导的 mxnet、微软主导的 CNTK、百度主导的 PaddlePaddle 均支持。Cloud AI 100 还支持 ONNX runtime,一项由 Facebook 科学家提出并主导的跨深度学习框架兼容技术。

毫无疑问,Cloud AI 100 不是行业里唯一的基于 ASICs 的云端 AI 加速器:TPU 已经被 Google 商用化超过两年,而且在训练和推理双修 (training & inferencing) 英特尔收购的 Nirvana 等公司都在这一块业务上有不错的进展——现在高通也参与到竞争当中,意义和带来的价值在哪里?

这个问题的答案或许可以从高通的历史找到。经过多年,骁龙 SoC 已经成为智能手机处理器行业的标准,而骁龙产品线(除了某几年)的优势正是在不断降低功耗和发热的基础上带来不断提高的性能。

因此,高通认为低功耗、少发热就是自己在芯片组设计上的核心优势,而这个优势不仅可以被手机终端消费者所享受,它对于规模不断增大,已经在制造温室气体的服务器、数据中心,以及数据中心背后的科技公司来说,也有很大的用处。

降低用电、减少发热是数据中心都想要实现的。而实现它可以有多种不同的角度切入。内存解聚 (memory disaggregation) 是一种,通过各种技术减少服务器机架内的内存使用;将 AI 计算从 CPU、GPU 迁移到 FPGA 以及 Cloud AI 100 这样的专用 AI 加速器也是一种,因为它们在架构上本身就更适合专门类型的机器学习推理计算。

Google 显然为 AI 研究和应用的行业开了一个好头,推出并且重度使以来 TPU 算是对 CPU、GPU 的一次挥手道别。

还是用行业的经典案例来说明这件事:直到新范式的计算设备(比如量子计算)真正可用之前,未来都是属于专门 AI 加速器的时代,它和 AI 应用场景的关系,就像多年以前的 x86 CPU 和 Windows 那样,是支持更强大的计算、激活新的使用场景,为应用软件赋能的核心硬件。